La mise en place d’une stratégie de référencement naturel en entreprise relève souvent du challenge. Même lorsqu’il existe des équipes dédiées à cette tâche, il n’est pas rare que des divergences de point de vue surviennent sur les priorités, les méthodes et les moyens nécessaires pour obtenir un référencement naturel efficace, surtout quand le site internet n’a pas été créé par l’équipe en place ou si les outils pour y parvenir sont inadaptés voire inexistants. Voici les différents problèmes dont on entend souvent parlés dans les entreprises que nous rencontrons en tant qu’expert en référencement naturel et nos conseils SEO pour y résoudre.

L’héritage d’un site internet

Qu’ils soient propriétaires ou CMS, les sites internet de l’ancienne équipe dirigeante ou informatique sont souvent sources de problèmes. Certains sites auront une potentialité de référencement naturel, d’autres non et bien souvent le degré d’appropriation peut être élevé.

Conseil SEO :

Décrire les tâches et les potentialités du site internet tel que vous l’avez obtenu. Il peut s’agir par exemple des :

-différents modules ou plug-in possibles

-modèles de conception

-types de redirections possibles

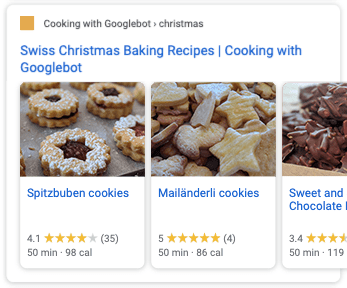

-des données structurées

-les liens internes

-modifications du site

S’il s’avère impossible de réaliser ces tâches, il faudrait envisager de mettre à jour le CMS ou de migrer vers un nouveau site.

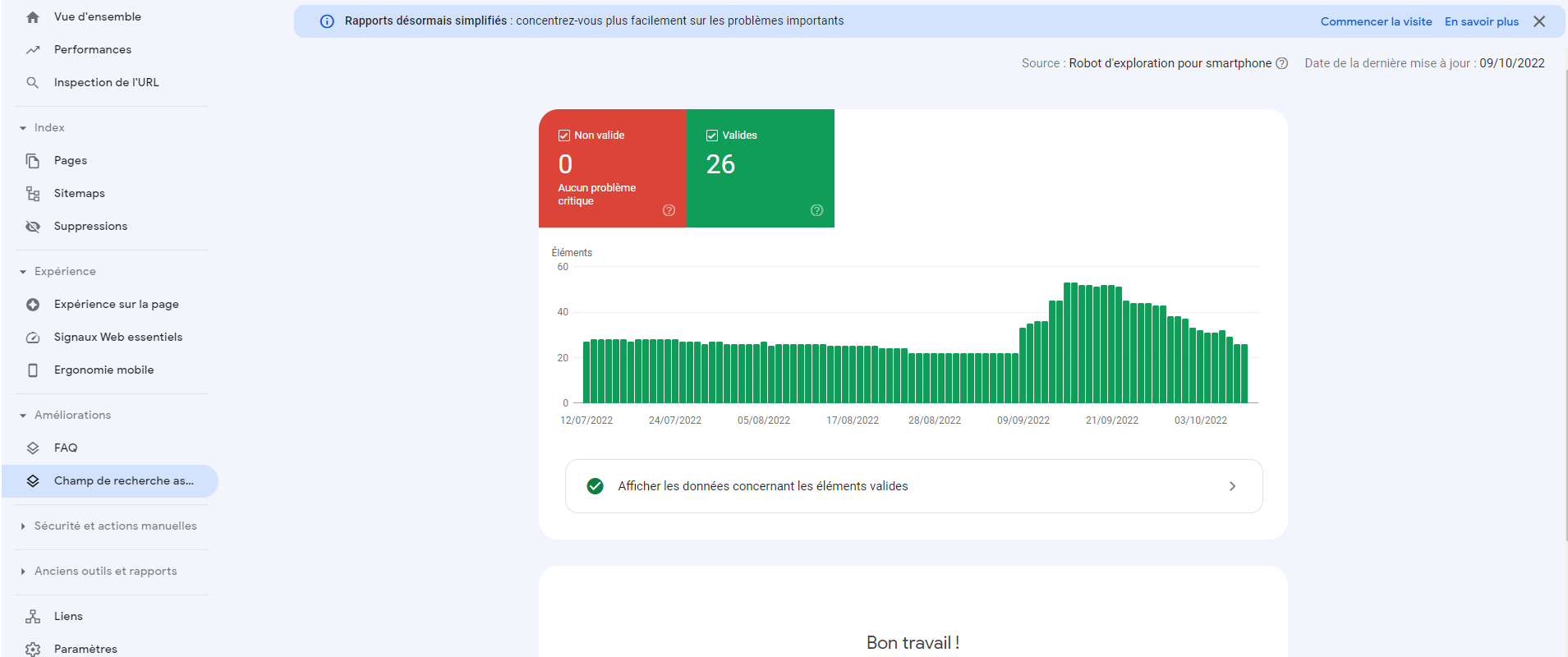

Ne pas utiliser des outils de travail efficaces

Malgré leurs promesses marketing, certains outils de travail (logiciels, plateformes internet…) peuvent se révéler inefficaces ou inappropriés à vos méthodes de travail. En cela, ils vous font donc perdre du temps ET de l’argent.

Conseil SEO :

Analyser et répertorier les outils efficaces et ceux qui vous freinent dans le développement de votre activité.

Consultez ou reconsultez vos fournisseurs pour discuter des options possibles et supprimez les outils dont les fonctionnalités ne permettent pas une optimisation pour les moteurs de recherche.

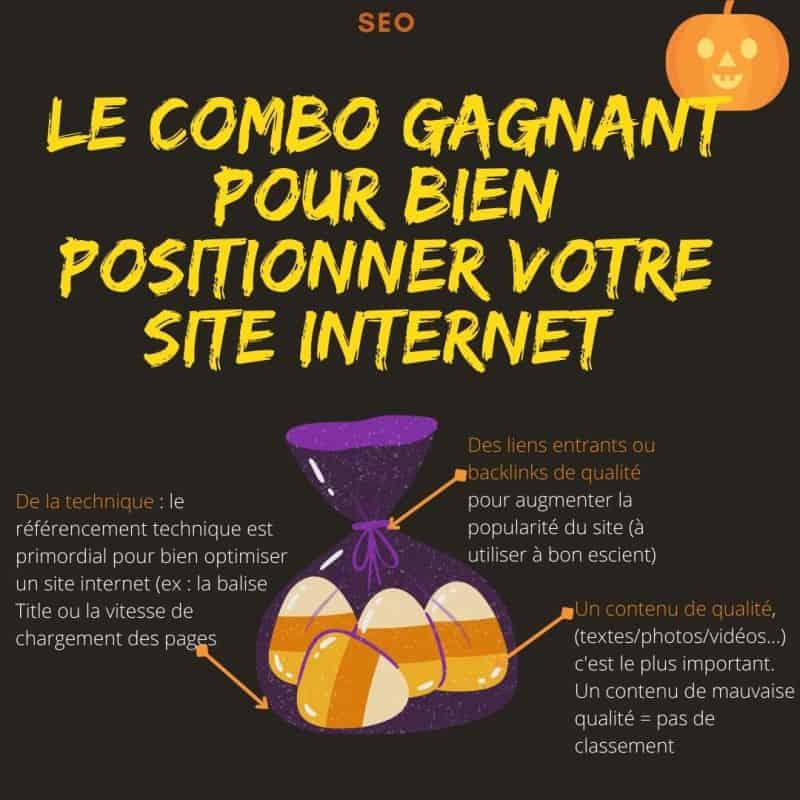

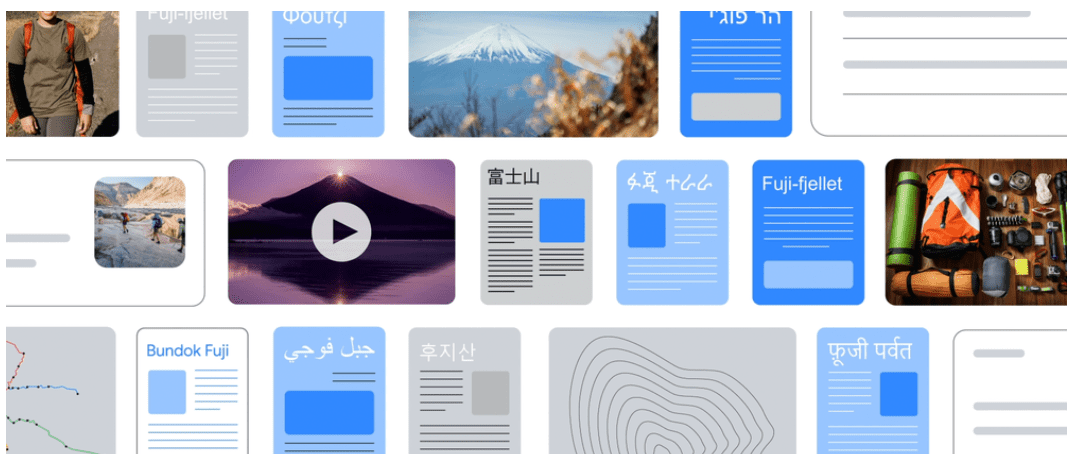

Un déploiement de contenus inappropriés qui vous pénalisent

Une stratégie de contenu qui ne répond pas aux attentes de votre cible peut être synonyme de perte d’opportunités pour l’entreprise.

Conseil SEO :

Mettre en place une procédure pour aligner vos différentes équipes sur une même stratégie pour élaborer des contenus plus efficaces. Vous pouvez commencer par :

-mettre en place une stratégie de référencement naturel globale, à l’échelle de l’entreprise

-créer un calendrier de contenus ou éditorial pour l’ensemble de l’entreprise

-élaborer des workflows et veiller à leur mise à jour régulière

-désigner les responsables et les intermédiaires de chaque tâche (éditeurs, rédacteurs et valideurs) avant le déploiement des contenus

-veiller à ne pas cannibaliser vos propres contenus avec, par exemple des titres de page en double, des copié-collé, etc.

Plusieurs mini sites web qui demandent du temps et des moyens

Il peut arriver qu’une entreprise gère plusieurs petits sites conçus au fil du temps. Mais voilà, la gestion de ces mini-sites peut devenir compliquée.

Conseil SEO :

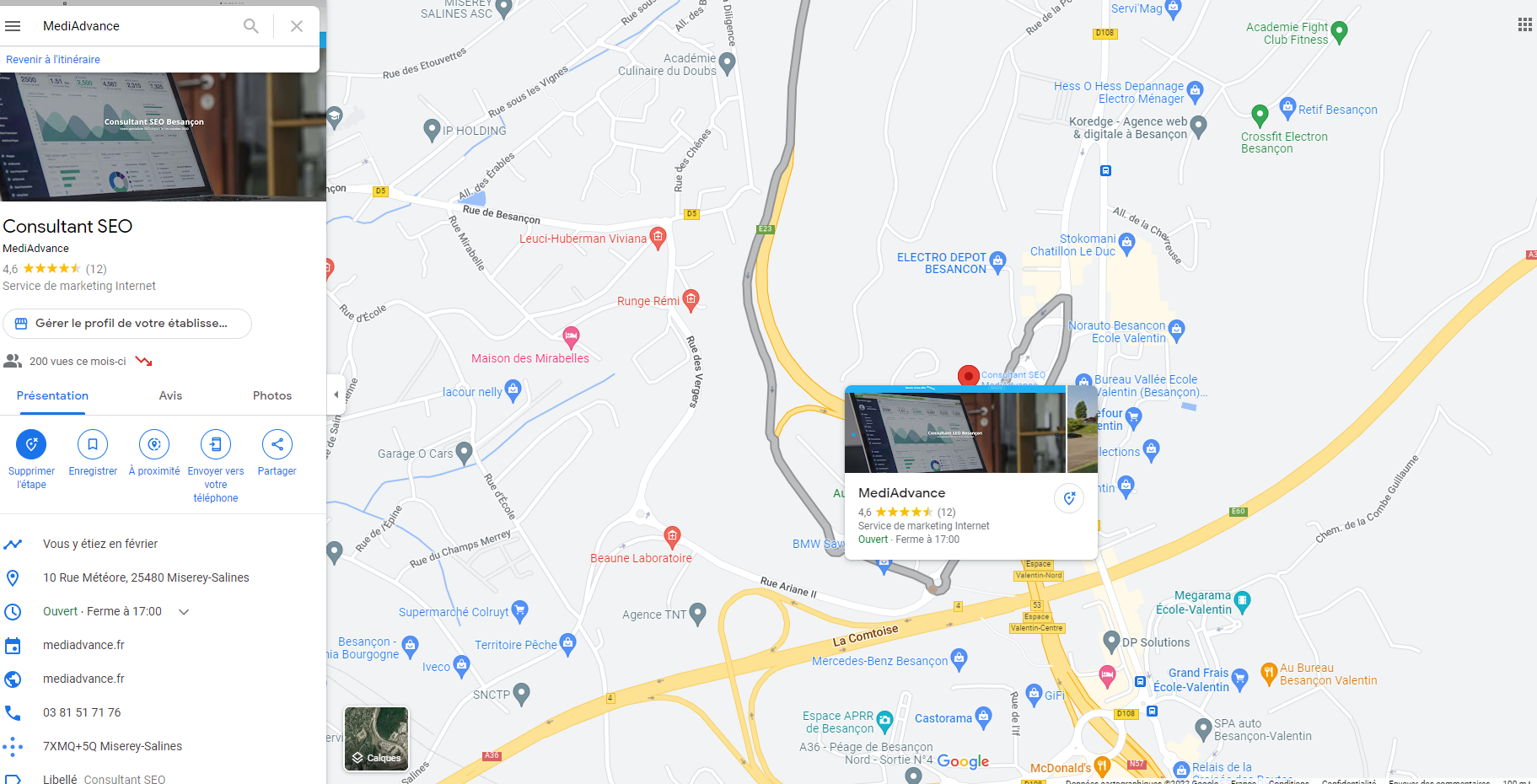

Même s’ils sont gourmands en ressources, faites de ces mini sites web une source d’informations plus ciblées et un moyen d’avoir des backlinks de qualité vers votre site internet principal.

Des développeurs web qui n’adhèrent pas à la stratégie SEO de l’entreprise

Ce n’est pas souvent le cas et pourtant, le développeur web / service informatique et le référenceur / service marketing doivent s’approprier la stratégie SEO de l’entreprise pour travailler main dans la main.

Conseil SEO :

Ces deux parties sont indispensables pour le référencement technique du site internet de l’entreprise.

Référenceur web et développeur web doivent étroitement collaborer pour :

-discuter des projets

-parler des problèmes rencontrés par l’une et l’autre des parties

-étudier les solutions possibles

-partager et se féliciter des réussites comme lorsque les évolutions informatiques mises en place ont permis d’optimiser la vitesse du site et améliorer son positionnement dans les résultats de recherche.

Le manque d’adhésion en interne

Les résultats sont bons grâce à la stratégie mise en place et au travail de tous, mais malheureusement, la direction ne veut pas modifier ou augmenter le budget marketing car ce qui est déjà mis en place “marche“, alors à quoi bon ? C’est exactement ce genre d’état d’esprit qui à tendance à nuire à l’esprit d’équipe et au manque d’adhésion.

Conseil SEO :

Pour pousser les collaborateurs à adhérer à la stratégie de l’entreprise, il faudrait davantage les impliquer et communiquer sur :

-les résultat obtenus

-l’impact des résultats des différentes campagnes de référencement naturel sur l’entreprise

-partager les expériences des différents collaborateurs impliqués ou non dans le dossier

Parce que les collaborateurs, plus qu’avant, désirent savoir comment par leur travail ils contribuent à l’essor de leur entreprise.

Faire fi des problèmes de référencement technique

Bien souvent les entreprises ont tendance à laisser les soucis techniques s’accumuler dans le temps :

-lenteur de la vitesse du site

-structure de liens internes manquante

-présence de contenus dupliqués

-balises canoniques absentes

-temps de réponse du serveur trop long

-…

Conseil SEO :

Si ces problèmes sont réglés au fur et à mesure, les objectifs SEO seront plus facilement et rapidement atteints.

Les erreurs de redirections multiples

Les redirections peuvent vite devenir incontrôlables et causer beaucoup de tort à une campagne d’optimisation de référencement naturel.

Solution SEO :

Pour éviter l’anarchie, il faut très tôt s’attacher à :

-corriger les redirections et les liens brisés

-corriger les chaînes de redirections

-automatiser la recherche de redirections

-mettre en place une base de données de redirections

-mettre en place une politique de gestion des redirections

Source : Searchengineland